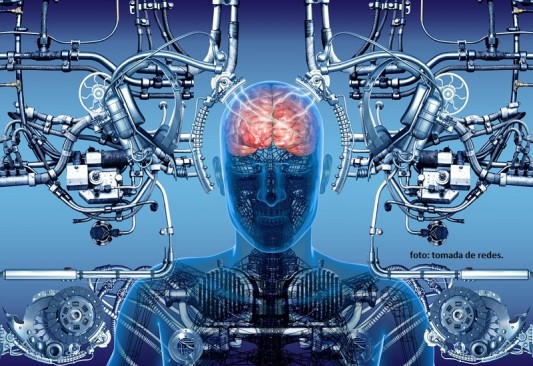

¡Cuidado! Alertan por intentos de extorsión usando la Inteligencia Artificial (video)

En diferentes espacios se está alertando a la ciudadanía sobre una nueva forma de extorsionar, ahora a través de la Inteligencia Artificial.

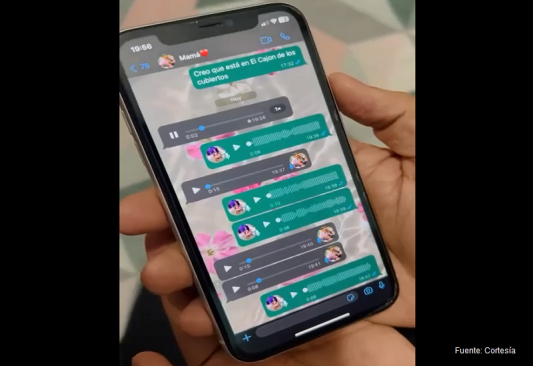

Y es que mediante el uso de diferentes programas, los delincuentes pueden clonar la voz de cualquier persona, haciéndole creer a las víctimas que se trata de un amigo o familiar.

Desde hace muchos años los extorsionadores han usado la historia de que habla un familiar de los Estados Unido, un ejecutivo de su banco o que tienen a un ser querido secuestrado.

Muchas personas fueron víctimas entonces, y se espera que la cifra ahora sea mucho mayor con las herramientas de la tecnología, pues realmente será la voz de ese ser querido.

Con pocos conocimientos de computación, cualquier persona puede clonar la voz de un tercero y utilizarla para extorsionar a su familia o engañarlos para obtener algún beneficio.

Por ello, se lanza una alerta a la ciudadanía para que este muy al pendiente de cualquier mensaje que reciba, pues podría tratarse de un engaño, aun y cuando la voz del interlocutor sea muy parecida o exactamente igual a la de un amigo o familiar.

Compartir nota